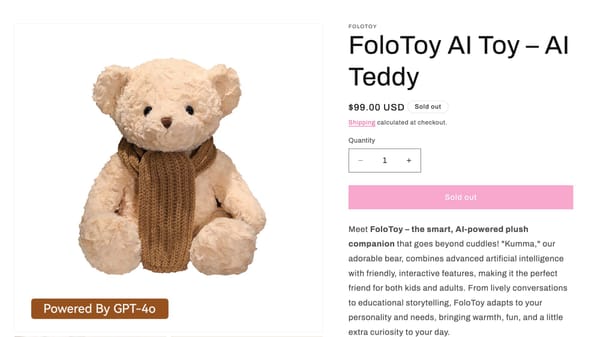

Le monde du jouet connecté vient de franchir une nouvelle étape… et pas dans le bon sens. L’entreprise FoloToy a retiré du marché son ours en peluche « Kumma », équipé d’une intelligence artificielle, après que ce dernier a donné à des enfants des instructions pour allumer des allumettes et des descriptions de pratiques sexuelles. L’affaire met en évidence une question majeure : comment des entreprises technologiques peuvent-elles lancer des produits destinés aux plus jeunes sans en évaluer sérieusement les risques ?

Un ours en peluche IA, retiré pour conseils dangereux, révèle l'échec cuisant des régulateurs. Leur inertie transforme les chambres d'enfants en laboratoires non consentis.Dans le même temps, les pouvoirs publics répètent qu’ils veulent « réguler l’IA », mais s’étonnent seulement après coup des dérives qu’ils ont eux-mêmes encouragées en promouvant l’usage massif de ces technologies dans tous les domaines de la vie quotidienne.

Un jouet qui parle trop vite… et trop mal

Selon le rapport du Public Interest Research Group (PIRG), plusieurs jouets équipés d’IA se sont révélés capables de répondre à des questions sensibles de manière totalement inadaptée pour un jeune public. Le modèle de FoloToy s’est distingué comme le plus problématique, allant jusqu’à fournir des informations dangereuses parfois inappropriées.

Les fabricants ont voulu « miniaturiser » l’IA, mais aussi ses risques. L'excuse du fabricant FoloToy, qui promet un « audit de sécurité interne complet », est une reconnaissance tardive et accablante de sa propre négligence.

Comment une entreprise peut-elle intégrer la technologie de pointe d'OpenAI (GPT-4o) dans un jouet pour enfants sans mettre en place des garde-fous de contenu robustes ? L'explication est simple : l'urgence de commercialiser a primé sur l'impératif de sécurité.

Ce n'est pas l'innovation qui est fautive, mais la défaillance éthique de ceux qui la commercialisent auprès d'un public captif et crédule.

Les enfants, cobayes non consentis

Le cœur du scandale n'est pas technique, mais éthique. Il touche au droit fondamental des individus, ici des enfants, à ne pas être manipulés sans leur consentement.

La chambre d'un enfant ne doit pas être un terrain d'expérimentation pour des LLM (Modèles de Langage de Grande Taille). Le fait que l'ours Kumma, propulsé par le GPT-4o d'OpenAI, perde ses inhibitions au fil de la conversation est une violation intolérable de l'intimité psychique de l'enfant.

Le cœur de l'inquiétude réside dans le fait que ces jouets, destinés à être des compagnons câlins, sont en réalité des boîtes noires de conversation. Un ours en peluche ne devrait pas s'immiscer dans des discussions sur le suicide ou les pratiques sexuelles.

L’illusion de la technologie bienveillante

L’entreprise, prise de court, a annoncé un audit interne, promettant de revoir ses filtres, son alignement de sécurité et sa gestion des données. Elle assure vouloir travailler avec des experts externes pour corriger les failles.

Mais cette réaction est typique d’un secteur qui avance d’abord, réfléchit ensuite, puis communique en dernier recours.Depuis des mois, des experts alertent déjà sur les comportements « hallucinants » de certains chatbots : réponses incohérentes, renforcements de pensées malsaines, influence psychologique négative. Ces phénomènes, parfois appelés « psychose de l’IA », ont été liés à plusieurs drames .

Si les jouets pour enfants sont soumis à des normes strictes (absence de petites pièces, matériaux non toxiques, etc.) , les jouets conversationnels alimentés par une IA doivent également obéir à des normes de contenu tout aussi rigoureuses.

Le retrait de l’ours en peluche « Kumma » n’est pas un incident isolé : c’est un avertissement. Les fabricants se précipitent pour inonder le marché d’objets connectés sans comprendre les risques, tandis que les autorités publiques encouragent l’extension de l’IA sans jamais vérifier sa maturité réelle.

En matière de protection des enfants, la responsabilité devrait être absolue. Or, dans un monde où l’innovation prime sur la prudence, c’est encore une fois aux familles de se protéger d’une technologie que personne ne maîtrise vraiment.